深度学习超参数的介绍

深度学习超参数的介绍

学习率

深入理解神经网络学习率(定义、影响因素、常见调参方法、关键代码实现)

深度学习中的学习率(Learning Rate)是一个至关重要的超参数,它决定了模型在训练过程中更新权重参数的速度与方向。在使用梯度下降法(Gradient Descent)或其变种(如随机梯度下降,Stochastic Gradient Descent, SGD)优化模型时,学习率扮演着核心角色。

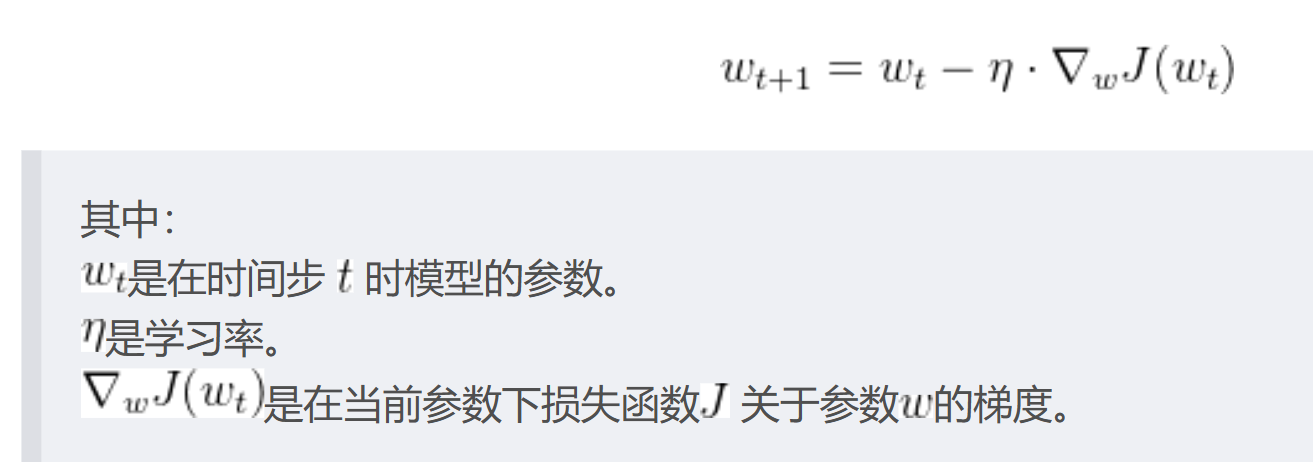

具体来说,在每次迭代过程中,模型计算损失函数关于各个参数的梯度,这个梯度指示了参数应当朝着哪个方向调整以最小化损失。学习率就是这个调整过程中的“步伐”大小,即参数更新的量。数学表达式通常是这样的:

如果学习率设置得过大,那么在每一步迭代中,模型参数可能会跨过最优解,导致震荡或者发散,这被称为“振荡现象”或“不稳定性”。相反,如果学习率设置得太小,模型收敛到最优解的速度将会非常慢,而且可能会陷入局部极小点,而不是全局最优解。

过拟合和欠拟合(Overfitting and underfitting)

过拟合和欠拟合是导致模型泛化能力不高的两种常见原因,都是模型学习能力与数据复杂度之间失配的结果。

“欠拟合” 常常在模型学习能力较弱,而数据复杂度较高的情况出现,此时模型由于学习能力不足,无法学习到数据集中的“一般规律”,因而导致泛化能力弱。

“过拟合” 常常在模型学习能力过强的情况中出现,此时的模型学习能力太强,以至于将训练集单个样本自身的特点都能捕捉到,并将其认为是“一般规律”,同样这种情况也会导致模型泛化能力下降。

Overfitting

过拟合(over-fitting)也称为过学习,它的直观表现是算法在训练集上表现好,但在测试集上表现不好,泛化性能差

cause

- 训练集的数据太少或者缺乏代表性;

- 训练集样本存在的噪音干扰过大,导致模型拟合了噪音的特征,反而忽略了真实的输入输出间的关系;

- 参数太多,模型复杂度过高;

method

- 增加数据量

- 从数据源头获取更多数据;

- 通过数据增强对数据进行扩充:对图像进行翻转、裁剪、缩放、平移、添加噪声等。

- 正则化

在进行目标函数或代价函数(损失函数)优化时,在函数后面加上一个正则项,一般有L1正则、L2正则等。

- L1正则化: L1正则化是通过在目标函数中加入L1范数惩罚项来实现的。L1范数是指权重向量W中的各个元素绝对值之和,因此L1正则化的目的是使模型参数尽可能地稀疏。L1正则化可以促使模型参数向零值收缩,进而减少特征的数量。

- L2正则化: L2正则化是通过在目标函数中加入L2范数惩罚项来实现的。L2范数是指权重向量W中的各个元素的平方和开根号,因此L2正则化的目的是通过约束模型参数的平方和,使得它们的值不会过大。L2正则化可以帮助避免模型的权值过拟合,并使得模型更具有鲁棒性和泛化能力。

区别: L1正则化减少的是一个常量,L2正则化减少的是权重的固定比例;使用L1可以得到稀疏的权值,使用L2可以得到平滑的权值;实践中L2正则化通常优于L1正则化。

- Dropout

Dropout 是一种常用的正则化技术,用于减少深度神经网络的过拟合现象。Dropout 在训练过程中随机地丢弃一部分神经元的输出,从而强制模型去学习其他特征的表示。

欠拟合(Underfitting)是指模型在训练数据上的表现就不够好,无法捕捉数据的基本趋势和模式,导致模型的预测或分类能力较差。以下是欠拟合的原因和一些解决方案:

欠拟合的原因

模型太简单:如果模型结构过于简单,可能无法捕捉数据的复杂特征和关系。

训练数据不足:过少的训练样本可能导致模型无法学习到足够的信息。

特征选择不当:如果重要的特征被忽略或未被正确使用,模型可能无法学习到数据的真实结构。

训练时间不足:模型可能需要更多的迭代次数来充分学习数据的特征。

学习率过高:如果学习率设置得过高,可能导致模型在训练过程中震荡,无法收敛到最优解。

正则化过度:过度的正则化可能会限制模型的复杂度,导致模型无法拟合数据。

数据预处理不当:如数据未归一化或标准化,可能导致模型训练效果不佳。

错误的模型选择:选择了不适合当前数据分布和问题的模型。

解决方案

增加模型复杂度:增加模型的层数或神经元数量,使模型能够捕捉更复杂的特征。

获取更多数据:增加训练数据量,提供更多的信息供模型学习。

特征工程:通过特征选择、特征提取或特征构造等方法,增加模型的预测能力。

延长训练时间:增加迭代次数,让模型有更多的机会学习数据。

降低学习率:适当降低学习率,确保模型能够稳定地收敛。

减少正则化强度:减少L1或L2正则化项的系数,或使用其他类型的正则化方法。

数据预处理:确保数据被正确地预处理,如归一化、标准化或去噪声。

选择合适的模型:根据数据的特点和问题的需求,选择合适的模型类型。

使用集成学习:通过组合多个模型的预测结果,提高模型的整体性能。

调整训练策略:如使用不同的优化算法或调整其他超参数,可能会改善模型的训练效果。

模型解释性:使用模型解释性工具来理解模型的预测,识别模型未能捕捉的特征。

交叉验证:使用交叉验证来评估模型在不同数据子集上的表现,确保模型的泛化能力。

通过这些方法,可以提高模型的拟合度,使其在训练数据上能够更好地捕捉数据的基本趋势和模式。在实际应用中,通常需要通过实验和调整来找到最佳的解决方案。

损失函数、代价函数、目标函数

当然,以下是对损失函数、代价函数和目标函数的总结,包括它们的定义和区别:

| 术语 | 定义 | 区别与联系 |

|---|---|---|

| 损失函数(Loss Function) | 衡量模型预测值与实际值差异的函数,用于训练过程中评估模型性能。 | 通常是代价函数的具体实现,关注单个样本的预测误差。 |

| 例如:均方误差(MSE)、交叉熵损失(Cross-Entropy Loss) | ||

| 代价函数(Cost Function) | 衡量模型整体性能的函数,通常是损失函数对所有样本的累积或平均。 | 比损失函数更广泛,可以包含正则化项等,用于选择最优模型参数。 |

| 例如:正则化的均方误差、总交叉熵损失 | 通常是训练过程中优化的目标。 | |

| 目标函数(Objective Function) | 用于优化问题的函数,通常结合了代价函数和其他考虑因素。(经验风险+结构风险) | 可以包含代价函数,也可以包含其他优化目标,如公平性、可解释性。 |

| 例如:带有约束的目标函数 | 用于指导模型训练和评估,是最终优化的目标。 |

详细说明:

损失函数:

- 用于衡量单个样本的预测误差。

- 常见的损失函数有:

- 均方误差(MSE):[ \text{MSE} = \frac{1}{n} \sum_{i=1}^n (y_i - \hat{y}_i)^2 ]

- 交叉熵损失:[ \text{Cross-Entropy Loss} = -\frac{1}{n} \sum_{i=1}^n [y_i \log(\hat{y}_i) + (1 - y_i) \log(1 - \hat{y}_i)] ]

- 损失函数的选择取决于问题类型(如回归或分类)。

代价函数:

- 通常指代整个数据集上的损失函数的总和或平均。

- 可以包含正则化项来防止过拟合,如:

- L1正则化:[ \text{Cost} = \text{MSE} + \lambda \sum_{j=1}^m |w_j| ]

- L2正则化:[ \text{Cost} = \text{MSE} + \lambda \sum_{j=1}^m w_j^2 ]

- 代价函数是训练过程中需要最小化的函数。

目标函数:

- 综合了代价函数和其他优化目标(如约束条件)。

- 可以是多目标优化问题的一部分,考虑多个不同的目标,如:

- 准确性:模型的预测准确性。

- 公平性:模型在不同群体上的表现。

- 可解释性:模型决策的透明度。

- 目标函数是最终优化的目标,指导模型的训练和评估。

在实际应用中,这些术语有时可以互换使用,但它们在概念上有所区别。理解这些区别有助于更准确地描述和优化机器学习模型。

监督,无监督,半监督,弱监督学习

在机器学习和人工智能领域,这些术语描述了不同的学习模式和方法:

监督学习(Supervised Learning):

- 监督学习是一种机器学习类型,其中模型从标记的训练数据中学习。这些数据包括输入特征和相应的输出标签。

- 模型的目标是学习一个函数,能够从输入特征映射到正确的输出标签。

- 常见的监督学习任务包括分类(如垃圾邮件检测)和回归(如房价预测)。

半监督学习(Semi-Supervised Learning):

- 半监督学习是监督学习的一种变体,其中训练数据包含一部分标记样本和一部分未标记样本。

- 这种方法通常用于标签获取成本高昂,但未标记数据容易获得的情况。

- 半监督学习模型利用未标记数据来提高学习性能,同时利用标记数据来指导学习过程。

弱监督学习(Weakly Supervised Learning):

- 弱监督学习涉及到使用不精确或不完整的标签进行学习。这种标签可能是噪声较大的、部分正确的或非常粗略的。

- 与监督学习不同,弱监督学习不要求精确的标签,而是允许一定程度的错误或模糊性。

- 这种学习模式适用于标签获取困难或成本高昂的情况,例如从文本描述中自动提取信息。

无监督学习(Unsupervised Learning):

- 无监督学习是一种机器学习类型,其中模型从未标记的数据中学习,没有提供任何输出标签。

- 模型的目标是发现数据中的结构和模式,例如通过聚类或降维技术。

- 常见的无监督学习任务包括聚类(如市场细分)和关联规则学习(如购物篮分析)。

这些学习模式各有优势和适用场景,选择哪一种取决于具体问题的性质、数据的可用性以及所需的输出类型。